Im Wettbewerb um Kunden und Märkte benötigen Unternehmen immer mehr Daten – schnell, zuverlässig und für ganz unterschiedliche Anwendungsfälle. Ebenso gilt es, sich die Möglichkeiten von Künstlicher Intelligenz und Echtzeitanalysen zu Nutze zu machen. Als Schlüsseltechnologien etabliert sich hierbei zunehmend Databricks, eine Sammlung verschiedener Open-Source-Tools, die im Gewand derAzure Cloud sehr einfach zu nutzen sind.

Aber was ist so besonders an Databricks? In diesem Databricks FAQ finden Sie Antworten auf die fünf wichtigsten Fragen:

- Was sind die Vorteile von Databricks?

- Wo kann ich Databricks einsetzen?

- Wie wird die Sicherheit bei Databricks geregelt?

- Wer sollte Databricks verwenden?

- Wie viel kostet Databricks?

1. Was sind die Vorteile von Databricks?

Databricks ist ein Universalwerkzeug zur Verarbeitung, Transformation und Bereitstellung großer Datenmengen für ganz unterschiedliche Analyseszenarien. Der Cloud-Service zeichnet sich durch eine hohe Performance, Skalierbarkeit und Flexibilität aus.

Folgende Vorteile ergeben sich daraus:

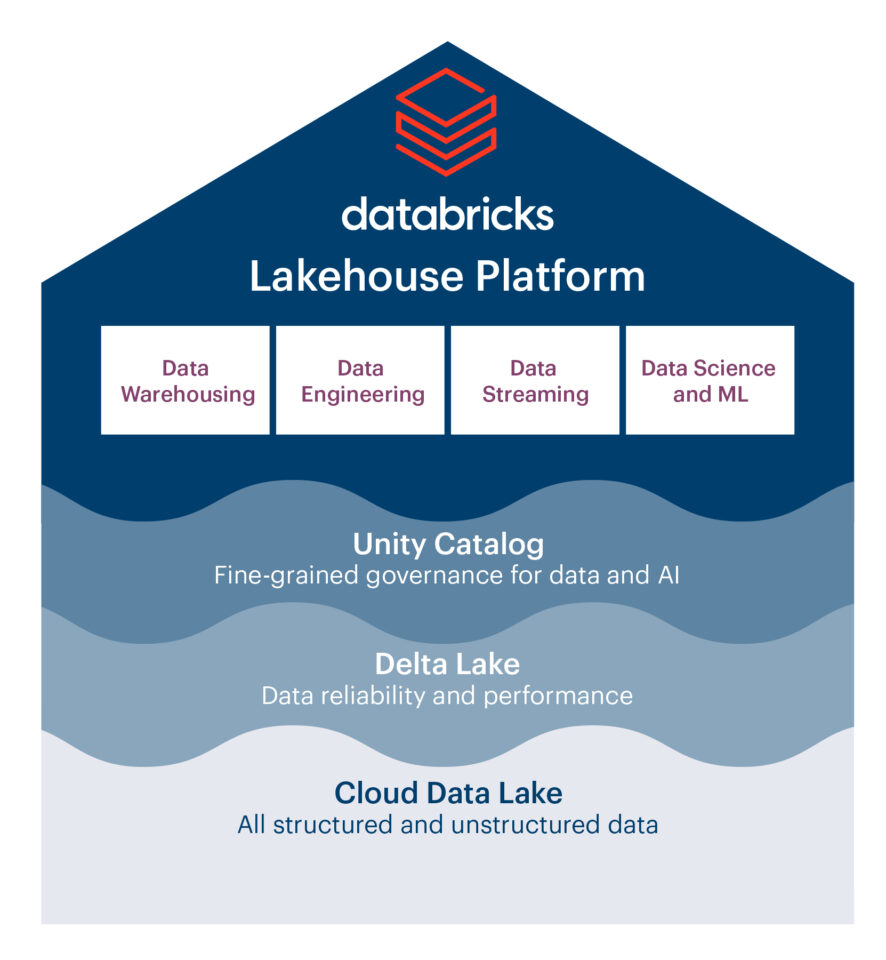

- Data Lakehouse als zentrale Plattform

- Einfach einzurichten und zu betreiben

- Interaktive Arbeitsbereiche für die Zusammenarbeit

- Alle Analyseanforderungen werden abgedeckt

- Gezahlt wird nur nach Nutzung

Data Lakehouse als zentrale Plattform

Rund um Databricks lässt sich in der Azure Cloud schnell und effizient eine vollständige Data-Lakehouse-Architektur aufbauen. Mit einem Databricks Lakehouse können Sie nahezu unbegrenzte Datenmengen und -formate bedarfsgerecht erfassen und weiterverarbeiten. Alle Nutzer vom Data Engineer über den Business Analysten bis hin zum Data Scientist haben immer Zugriff auf die Daten, die für das Erreichen ihrer Business-Ziele relevant sind. Zudem fördern Sie die datengetriebene Zusammenarbeit zwischen den verschiedenen Unternehmensbereichen – ganz ohne Medienbrüche und mit umfangreichen Synergiepotenzialen für Ihr Geschäft.

Einfach einzurichten und zu betreiben

Gegenüber den komplexen Basistechnologien Apache Spark, Delta Lake und MLflow ist Databricks sehr einfach in der Handhabung. Der Cloud-Dienst lässt sich in Azure mit wenigen Klicks aufsetzen. Er ist vollständig gemanagt, sodass auch im laufenden Betrieb kaum Aufwände für Wartung und Updates anfallen. Sie müssen also keine komplizierten Infrastrukturen mehr einrichten und mit schwerfälligen Tools umgehen, um Ihre Big Data zu erschließen.

Interaktive Arbeitsbereiche für die Zusammenarbeit

Für die Zusammenarbeit verschiedener Experten stellt Databricks einen interaktiven Arbeitsbereich zur Verfügung. Der gemeinsame Arbeitsbereich ist mit Notebookfunktionen für das Coding ausgestattet und unterstützt viele beliebte Programmiersprachen wie SQL, Python, Java oder R. Entsprechend fühlen sich hier Data Engineers genauso zu Hause, wie Data Scientists und Business Analysten. Letztlich schaffen Sie ein dynamisches Arbeitsumfeld, in dem sich datengetriebene Innovationen deutlich schneller vorantreiben lassen.

Alle Analyseanforderungen werden abgedeckt

Databricks bedient sämtliche Anforderungen rund um Big Data und der modernen Datenanalyse auf einer Plattform. Sie müssen also nicht mehr verschiedene Tools in Anspruch nehmen, die für die jeweilige Aufgabe und Datenbankumgebung optimiert sind. Azure stellt zudem ergänzende Funktionen und Werkzeuge bereit. Vor allem für Nutzer, die grafische Oberflächen einer Coding-Umgebung vorziehen, ist dies eine Bereicherung. In der Folge lässt sich ein Spektrum abdecken, das von der Verarbeitung von Massendaten über die Analysen von Echtzeitdatenströmen bis hin zu maschinellem Lernen reicht.

Gezahlt wird nach Nutzung

Durch den Cloud-Ansatz bleiben auch die Kosten transparent und kontrollierbar. Rechenleistung und Speicherkapazität können unabhängig voneinander skaliert werden. Die Erhöhung der Rechenleistung erfolgt dynamisch. Bezahlt wird letztlich nur das, was der Anwender auch tatsächlich nutzt. So lässt sich beispielsweise die Rechenleistung – etwa für das Training von KI-Modellen – kurzfristig massiv steigern und dann direkt wieder herunterskalieren.

2. Wo kann ich Databricks einsetzen?

Mit Databricks decken Sie die gesamte Spannbreite unternehmensrelevanter Analyseszenarien ab:

- ETL/Datenintegration

- Explorative Analysen

- Echtzeitanalysen von Datenströmen

- Machine Learning/KI

ETL/Datenintegration

Mit dem Delta Lake besitzt das Databricks Lakehouse ein Speicherformat für die klassische Batch-Datenverarbeitung. So können typische Business-Intelligence-Aufgaben mittels ETL umgesetzt werden – sprich: Daten unterschiedlicher Systeme und unterschiedlichen Umfangs werden gefiltert, bereinigt, zusammengeführt und im Rahmen des Reportings bereitgestellt.

Explorative Analysen

Databricks ist in der Lage, die unterschiedlichen Data Lake Storages der gängigen Cloud-Anbieter zu nutzen. Mit Hilfe der hoch performanten Spark Engine können Data Engineer, Data Analyst und Data Scientist explorative Analysen nach ihren jeweiligen Vorstellungen und Zielen vornehmen.

Echtzeitanalysen von Datenströmen

Ebenso können Datenströme über den Delta Lake im Sekundentakt verarbeitet und analysiert werden. Dabei lassen sich auch Daten, die simultan von mehreren Systemen gesendet werden, in hoher Geschwindigkeit zusammenführen. Auf diese Weise werden beispielsweise Produktionsmaschinen und -strecken überwacht. Ebenso lassen die Datenströme zur Entwicklung smarter Produkte nutzten.

Machine Learning/KI

Mit MLflow verwalten Sie Workflows für maschinelles Lernen. Dabei deckt das Tool den gesamten Machine-Learning-Lebenszyklus ab. Modelle können während des Trainings und der Ausführung überwacht werden. Sie lassen sich in einem austauschbaren Format speichern, in den Produktionscode laden und schließlich in eine Pipeline überführen. So legen Sie die Basis für ganz unterschiedliche KI-Lösungen.

3. Wie wird die Sicherheit bei Databricks geregelt?

Beim Umgang mit sensiblen Daten stellt sich immer die Frage, wer in welchem Umfang darauf Zugriff haben darf. Mit dem Unity Catalog bietet Ihnen Databricks ein machtvolles Instrument, um selbst in konzernweiten Big-Data-Szenarien die notwendige Data Governance und Informationssicherheit zu gewährleisten. So können Sie einen global gesicherten, interdisziplinären Datenaustausch mit Self-Service im großen Maßstab realisieren.

Gleichzeitig ermöglicht Ihnen die Azure Active Directory eine rollenbasierte Zugriffssteuerung. Der Dienst kann in einem eigenen virtuellen Netzwerk genutzt werden, womit eigene Daten und Skripte effektiv von der Außenwelt abgegrenzt und gesichert sind.

4. Wer sollte Databricks verwenden?

Grundsätzlich ist der Einsatz von Databricks jedem Unternehmen zu empfehlen, das an die Grenzen seiner analytischen Möglichkeiten stößt – sprich: umfangreiche Datenmengen können zwar gespeichert, aber nicht mehr weiterverarbeitet werden. Entsprechend entfaltet der Service vor allem in großen Unternehmen und konzernweiten Datenlösungen einen hohen Wirkungsgrad. Databricks sprengt die Barrieren von isolierten Datensilos und macht vermeintlich schwierige oder sogar unlösbare Aufgabenstellungen plötzlich wieder einfach und handhabbar. So können Sie Ihre Daten umfassend erschließen und für unterschiedlichste geschäftliche Use Cases nutzen.

Zudem ist Databricks natürlich für all jene interessant, die bereits auf Cloud-Datenbanken in Azure setzen. Hier wird in technologischer Hinsicht das zusammengeführt, was zusammengehört. So ist der Ein- bzw. Umstieg besonders schnell und einfach zu bewerkstelligen. Die Multicloud-Fähigkeit von Databricks verhindert dabei einen Vendor Lock-in.

5. Wie viel kostet Databricks?

Da es sich bei Databricks um einen Cloud-Dienst handelt, hängen die Kosten von der konkreten Nutzung ab. Sie bestehen einerseits aus den Serverkosten, die beim Cloudanbieter anfallen (neben Microsoft bieten auch Amazon und Google den Dienst an). Anderseits werden die konkreten Nutzungskosten bzw. Databricks Units (DBUs) abgerechnet. Dabei ist die Anzahl der abgerechneten DBUs abhängig von der Server- und Clustergröße sowie der genutzten Laufzeit.

Daraus ergibt sich die folgende Berechnungsformel:

Kosten = (Anzahl Server * DBU) * h/Nutzung + (Anzahl Server * Instanzpreise) * h/Nutzung

Wollen auch Sie Azure Databricks nutzen, um eine zukunftsfähige Daten- und Analyseplattform für Ihr Unternehmen aufzubauen? Dann schauen Sie doch mal auf der Seite Databricks Lakehouse vorbei oder informieren Sie sich über unser Data Strategy Assessment.

Kommentare (0)